Suchmaschinen wie Google nutzen Web Crawling, damit Seiten im Suchindex bei Google erscheinen. Facebook und andere Soziale Medien crawlen, damit sie dir die optimalen Beiträge im Newsfeed anzeigen können. Amazon crawlt Produktseiten. Crawling ist somit ein wesentlicher Bestandteil, damit das Internet in seiner Form, wie wir es kennen, funktioniert. Stellt sich die Frage, was ist für dich drin? Wie kann crawling dir in deinen alltäglichen Herausforderungen helfen? Genau darum geht es in diesem Beitrag. Du erfährst, wie du mit Crawling Datensätze vervollständigen kannst, um zum Beispiel Preisvergleiche durchzuführen.

Was ist Web Crawling?

Crawling ist der Prozess des automatischen Scannens und Sammelns von Informationen aus Webseiten im Internet. Ein Website Crawler ist eine automatisierte Software, die zum Navigieren auf Webseiten, zum Extrahieren und zum Speichern von Daten verwendet wird.

Was ist Web-Scraping?

Unter Web-Scraping versteht man das automatisierte Extrahieren von Daten auf Webseiten oder auch Data-Scraping. Im Gegensatz zum Web-Crawling konzentriert der Web-Scraper sich auf bestimmte Daten, die Du extrahieren möchtest, und speichert sie in einem strukturierten Format, z. B. in einer Datenbank oder Tabellenkalkulationsdatei.

Einige beliebte Anwendungen von Web-scraping dienen der Extraktion von Kontaktinformationen, Produktdetails, Bewertungen und Preise Vergleichen. Es wird häufig von Datenwissenschaftlern und Forschern verwendet, um große Datenmengen zu sammeln, die für Analysen oder maschinelles Lernen verwendet werden können.

Wie hängen Web Crawling und Web-Scraping zusammen?

Obwohl Crawling und Scraping unterschiedliche Zwecke haben, können sie zusammen verwendet werden. Crawling wird zum Auffinden und Indizieren von Webseiten verwendet, während Scraping zum Extrahieren von Daten aus diesen Seiten eingesetzt werden kann. Durch die Kombination der beiden Verfahren kannst Du ein leistungsfähiges Data Harvesting-System aufbauen, das spezifische Informationen von Hunderten oder sogar Tausenden von Seiten auf einmal sammelt.

Wofür benötigt man Crawling und Scraping?

Das World Wide Web hält nahezu alle Informationen bereit. Der Prozess des manuellen Auslesens ist jedoch ressourcenintensiv und vor allem zeitaufwendig. Webseiten müssen manuell z.B. über die Nutzung von Suchmaschinen aufgerufen werden. Die benötigten Informationen müssen aufgefunden, identifiziert und zusammengetragen werden. Genau hier hilft ein Web Crawler. Dieser automatisiert den Prozess und liefert Daten auf dem Silbertablett, damit du dich auf deine Kernaufgaben konzentrieren kannst.

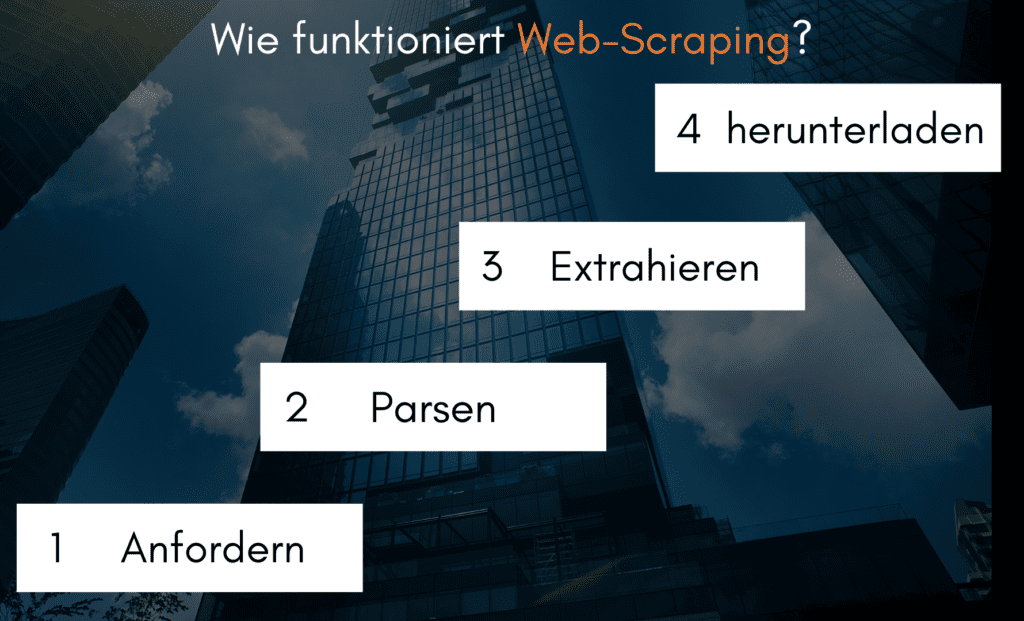

Wie funktioniert Web-Scraping?

Der Web-Scraping-Prozess besteht aus drei Schritten: Anfordern, Parsen und Extrahieren sowie Herunterladen von Daten.

Was ist Web-Scraping?

Der Web-Scraping-Prozess besteht aus drei Schritten: Anfordern, Parsen und Extrahieren sowie Herunterladen von Daten.

- Im ersten Schritt fragt der Web Scraper eine Ziel-Website nach dem Inhalt einer bestimmten URL ab. Der Scraper erhält dann die angeforderten Informationen im HTML-Format.

- Im zweiten Schritt, dem Parsen und Extrahieren, wird der Code geparst, um relevante Informationen wie Titel, Absätze, Überschriften, Links und fettgedruckten Text zu extrahieren – auch HTML-Parsing genannt.

- Im letzten Schritt werden die Daten heruntergeladen und in einer CSV-, JSON- oder Datenbank gespeichert. Diese Daten können dann abgerufen und manuell verwendet oder in anderen Programmen eingesetzt werden.

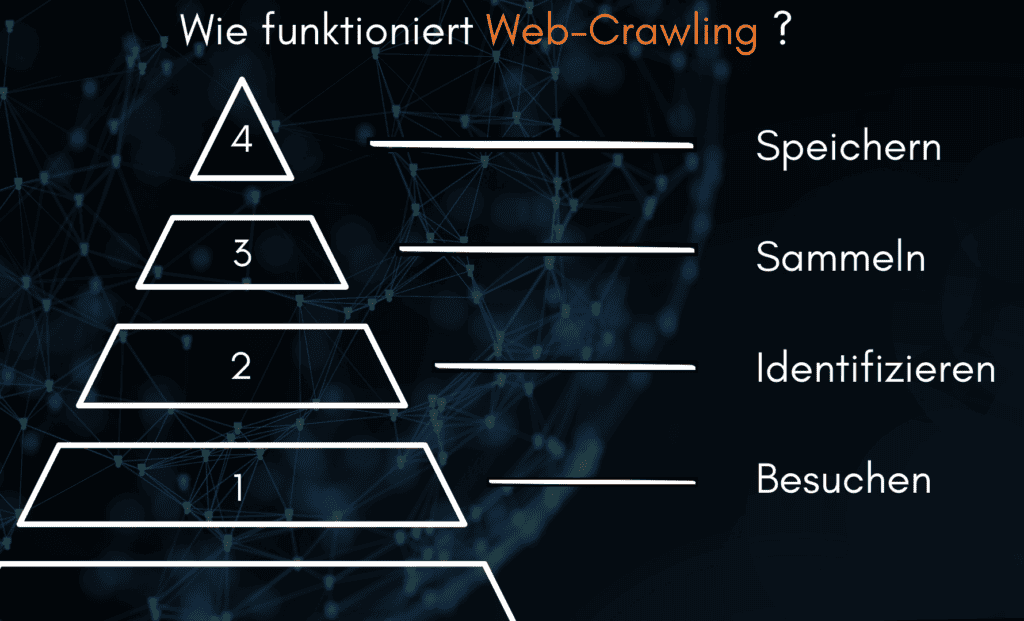

Wie funktioniert Web-Crawling?

Der Web-Crawling-Prozess besteht aus vier Schritten:

- Der Crawler besucht zunächst eine einzelne URL und analysiert deren Inhalt.

- Danach identifiziert er alle Links auf der Seite und besucht sie, um diesen Schritt zu wiederholen.

- Beim weiteren Besuch sammelt der Crawler von Seiten mit der Zeit immer mehr Daten.

- Der Crawler speichert und organisiert diese Daten in einem brauchbaren Format.

Welche Tools gibt es für Web-Crawling?

Es gibt verschiedene Web-Crawling-Tools, die von Open-Source-Frameworks wie Scrapy bis zu Unternehmenslösungen wie Apache Nutch reichen. Mit diesen Tools kannst Du Websites auf einfache Weise crawlen und nach Daten durchsuchen, und zwar auf effizientere und automatisierte Weise als beim manuellen Scraping. Zu den beliebten Open-Source-Frameworks gehören Selenium, Beautiful Soup und Requests. Unternehmenslösungen neigen dazu, mehr Funktionen und Möglichkeiten zu bieten, wie die Verwaltung umfangreicher Crawls, die Überwachung der Crawl-Ergebnisse und Exportoptionen.

Scrapy ist ein beliebtes Open-Source-Web-Crawling-Framework, das zur Extraktion von Daten aus Websites verwendet wird. Es ist in Python geschrieben und kann verwendet werden, um große Websites schnell und effizient zu crawlen.

Selenium ist ein weiteres beliebtes Open-Source-Framework für Web-Scraping, mit dem Du einen Browser steuern und Website-Inhalte durch Automatisierung auslesen kannst.

Beautiful Soup ist eine Bibliothek zum Parsen von HTML-Dokumenten, die häufig verwendet wird für Web Scraping. Es bietet eine einfache und leicht zu bedienende Schnittstelle zum Navigieren und Extrahieren von Daten aus HTML-Dokumenten.

Requests ist eine HTTP-Bibliothek, die das Abrufen von Websites mit Python-Code erleichtert. Mit ihr kannst Du problemlos Anfragen stellen, Antworten analysieren und Daten speichern.

Apache Nutch ist ein Web-Crawling-Framework auf Unternehmensebene, das für Data Mining und Scraping verwendet wird. Es ist in Java geschrieben und bietet Funktionen wie die Verwaltung großer Crawls, die Überwachung der Crawl-Ergebnisse und Exportoptionen.

Du siehst, dass das Thema beziehungsweise der Bau von einem Web Crawler technisch herausfordernd ist. Aus dem Grund empfehlen wir dir, die Zusammenarbeit mit einem Dienstleister.

https://crawling-dienstleister.de/kontakt/

Dies sind nur einige der verfügbaren Tools für das Web-Crawling. Mit Hilfe dieser Tools kannst Du problemlos Websitedaten extrahieren und mit anderen Anwendungen bearbeiten.

Welche Tools gibt es für Web-Scraping?

Für das Web-Scraping gibt es je nach Anwendungsfall viele verschiedene Web-Scraping-Tools. Einige der beliebtesten sind:

- Der ProWebScraper ist eine einfach zu bedienende Plattform für die Extraktion von Daten auf Websites. Diese bietet eine Point-and-Click-Schnittstelle und erfordert keine Programmierkenntnisse, um loszulegen.

- Webscraper.io ist eine Chrome-Erweiterung, mit der Nutzer auf einfache Weise Daten aus Websites extrahieren können, indem Du Sitemaps erstellst, die zeigen, wie die Website durchlaufen werden sollte und welche Information extrahiert werden sollte.

Anwendungen von Web-Crawling

Zu den Anwendungsbereichen des Web-Crawling gehören auch Data Mining, Stimmungsanalyse, Preisvergleiche und die Beobachtung der Aktivitäten von Wettbewerbern. Es können Informationen aus verschiedenen Quellen gesammelt werden, um einen umfassenden Überblick über ein bestimmtes Thema oder einen bestimmten Markt zu erhalten. Datenwissenschaftler nutzen Web Crawling für prädiktive Analysen und maschinelle Lernmodelle.

Webcrawler können auch für automatische Tests oder die Leistungsüberwachung von Websites eingesetzt werden. Web-crawler können mehrere Websites parallel crawlen und Probleme wie tote Links, langsam ladende Seiten oder fehlerhafte Inhalte aufspüren.

Sie werden auch eingesetzt, um Änderungen von Webinhalten im Laufe der Zeit zu überwachen und durch die Analyse Trends zu erkennen.

Anwendungen von Web-Scraping

Zu den Anwendungsbereichen des Web-Crawling gehören auch Data Mining, Stimmungsanalyse, Preisvergleiche und die Beobachtung der Aktivitäten von Wettbewerbern. Es können Informationen aus verschiedenen Quellen gesammelt werden, um einen umfassenden Überblick über ein bestimmtes Thema oder einen bestimmten Markt zu erhalten. Datenwissenschaftler nutzen Crawling für prädiktive Analysen und maschinelle Lernmodelle.

Webcrawler können auch für automatische Tests oder die Leistungsüberwachung von Websites eingesetzt werden. Web-crawler können mehrere Websites parallel crawlen und Probleme wie tote Links, langsam ladende Seiten oder fehlerhafte Inhalte aufspüren.

Sie werden auch eingesetzt, um Änderungen von Webinhalten im Laufe der Zeit zu überwachen und durch die Analyse Trends zu erkennen.

Anwendungen von Web-Scraping

Die Möglichkeiten gehen beim Web-Scraping sogar über diese Bereiche hinaus. Web Scraping kann auch für die Lead-Generierung, die Rekrutierung von Talenten, die Überwachung sozialer Medien und vieles mehr verwendet werden. Mithilfe von Web Scraping können Unternehmen Datenerfassungsprozesse automatisieren und wertvolle Erkenntnisse in einem Bruchteil der Zeit gewinnen, die für eine manuelle Erfassung erforderlich wäre. Web Scraping ist ein unschätzbares Werkzeug für jedes Unternehmen, das die Vorteile des Internets nutzen möchte. Zu den häufigsten Anwendungen gehören:

Aggregation von Inhalten

Verwende Web Scraper, um Daten von mehreren Websites zu sammeln und sie in einem umfassenden Bericht oder einer Datenbank zusammenzustellen.

Marktforschung

Mit Web Scraping lassen sich Daten über bestimmte Produkte, Preise, Konkurrenten, Kundenmeinungen und mehr extrahieren. Diese Informationen können dann für Marktanalysen verwendet werden.

Suchmaschinenoptimierung

Nutze Web Scraping, um herauszufinden, welche Schlüsselwörter und Phrasen von Ihrer Zielgruppe verwendet werden, und optimiere so den Inhalt Deiner Website.

Lead-Generierung

Web Scraping kann Unternehmen dabei helfen, Kontaktinformationen von potenziellen Kunden zu finden, z. B. E-Mail-Adressen, Telefonnummern und Profile in sozialen Medien. Diese Daten können dann für gezielte Werbung genutzt werden.

Rekrutierung von Talenten

Unternehmen können Web Scraping nutzen, um nach Bewerbern zu suchen, einschließlich ihrer Kontaktinformationen und früheren Berufserfahrung.

Überwachung sozialer Medien

Nutze Web Scraping, um Trends auf Social-Media-Plattformen zu überwachen und wertvolle Erkenntnisse über das Kundenverhalten zu gewinnen.

Maschinelles Lernen

Web Scraping wird verwendet, um große Datenmengen zu sammeln, die zum Trainieren von maschinellen Lernmodellen verwendet werden können.

Fazit

Web-Crawling und Web-Scraping sind leistungsstarke Werkzeuge zur Erfassung von Daten aus dem Internet. Sie können zur Automatisierung einer Reihe von Aufgaben eingesetzt werden, von der Marktforschung und Lead-Generierung bis hin zur Rekrutierung von Talenten und der Überwachung sozialer Medien. Mit der weiteren Entwicklung der Technologie wird Web-Scraping zu einer noch wertvolleren Ressource für Unternehmen, die Einblicke in ihre Märkte oder Kunden gewinnen wollen.

Häufig gestellte Fragen (FAQs)

Web Crawling, auch bekannt als Web Scraping oder Data Mining, ist ein Prozess der Datenextraktion auf Websites. Dabei werden Computerprogramme eingesetzt, um bestimmte Informationen auf einer Website zu identifizieren und zu extrahieren.

Web-Crawling bietet eine Reihe von Vorteilen, darunter automatische Datenerfassung, Lead-Generierung, Marktforschung und Überwachung sozialer Medien.

Zu den häufigsten Anwendungen von Web Scraping gehören die Zusammenstellung von Inhalten, Marktforschung, Suchmaschinenoptimierung, Lead-Generierung, Talentrekrutierung und Überwachung sozialer Medien. Es kann auch für maschinelles Lernen und Forschungszwecke verwendet werden.

Ja, Web-Scraping gilt im Allgemeinen als legal, solange es im Rahmen der Gesetze geschieht. Es ist wichtig, die Nutzungsbedingungen jeder Website, die Du scrapen möchtest, zu prüfen, da einige diese Praxis verbieten.

Web-Crawling ist der Prozess des automatischen Navigierens durch Websites, um Daten zu sammeln, während Web-Scraping der Prozess des Extrahierens bestimmter Informationen auf Websites ist. Beide werden zusammen verwendet, um große Datenmengen aus unstrukturierten Quellen im Internet zu sammeln.

Ja, wenn Du nicht vorsichtig bist, kannst Du Daten auslesen, die durch das Urheberrecht geschützt sind. Außerdem können einige Websites URLs die IP-Adressen sperren, wenn sie eine automatische Datenerfassung feststellen. Daher ist es wichtig, beim Web-Scraping die notwendigen Vorsichtsmaßnahmen zu treffen.